Asana vs. Trello: Welches Projektmanagement-Tool ist besser?

.svg)

Ein umfassender Mobile Web Test ist eine geschäftskritische Notwendigkeit für jedes digitale Produkt. Er stellt sicher, dass Ihre Webanwendung auf mobilen Geräten fehlerfrei funktioniert, schnell lädt und eine überzeugende User Experience bietet – unabhängig von Gerät, Betriebssystem oder Netzqualität.

Die mobile Nutzung hat den Desktop-Traffic längst überholt. Daher ist die Qualität der mobilen Erfahrung ein entscheidender Faktor für Erfolg oder Misserfolg. Nutzer erwarten eine absolut reibungslose Performance, egal ob sie im ICE mit schwankendem Netz surfen oder im stabilen WLAN sitzen.

Mobile Tests zu vernachlässigen, ist ein kostspieliger Fehler. Die direkten Konsequenzen sind gravierend: hohe Absprungraten, schlechte Bewertungen und ein wachsender Berg technischer Schulden, dessen Abbau später erhebliche Ressourcen bindet.

Jeder Bug, der unentdeckt in die Produktion gelangt, untergräbt das Nutzervertrauen. Eine langsam ladende Seite führt dazu, dass potenzielle Kunden abspringen, bevor sie Ihr Angebot überhaupt sehen. Ein nicht funktionierender Button im Checkout bedeutet direkten Umsatzverlust.

Ein strategischer Mobile Web Test ist keine Kostenstelle, sondern eine direkte Investition in Produktqualität und Kundenzufriedenheit. Er etabliert eine Kultur der Qualitätssicherung, die verhindert, dass Fehler überhaupt erst in die Produktion gelangen.

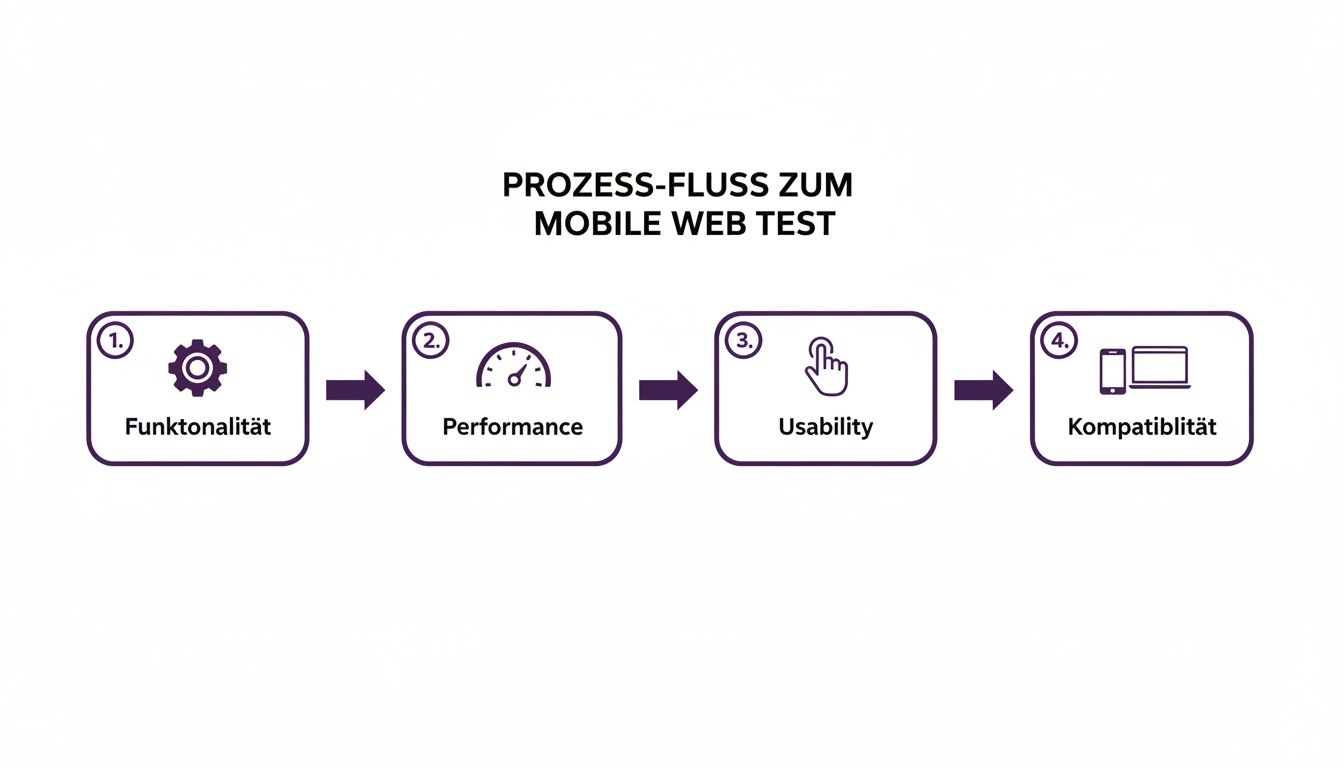

Ein robuster Testprozess muss auf vier fundamentalen Säulen stehen, die das Fundament für ein stabiles und erfolgreiches Produkt bilden.

Ein systematischer Ansatz, der diese vier Bereiche abdeckt, ist unerlässlich, um Risiken zu minimieren und eine Anwendung zu schaffen, die Nutzer gerne verwenden.

Eine effektive Teststrategie beginnt nicht beim Code, sondern bei den Geschäftszielen. Sie orientiert sich an den KPIs, die über den Erfolg Ihres Produkts entscheiden. Soll die Ladezeit unter zwei Sekunden gesenkt werden, um die Absprungrate zu reduzieren? Oder ist das Ziel, eine Conversion-Rate von mindestens 5 % im Checkout zu sichern? Das sind die Leitplanken für jeden sinnvollen Mobile Web Test.

Indem Geschäftsziele in technische Anforderungen übersetzt werden, entsteht ein klarer Fokus. Eine schnelle Ladezeit erfordert Performance-Tests unter realen Netzwerkbedingungen. Eine hohe Conversion-Rate verlangt nach robusten funktionalen Tests der wichtigsten User Journeys. Dieser zielgerichtete Ansatz verhindert, dass wertvolle Zeit in Tests investiert wird, die keinen messbaren Einfluss auf den Geschäftserfolg haben.

Sobald die Ziele stehen, muss der Testumfang realistisch definiert werden. Der Versuch, jede Funktion auf jedem erdenklichen Gerät zu prüfen, ist ineffizient. Ein risikobasierter Ansatz ist hier die pragmatische Lösung: Die Testaufwände werden dorthin gelenkt, wo das Geschäftsrisiko am größten ist.

Dafür werden Daten analysiert, welche Geräte und Browser die Zielgruppe tatsächlich nutzt. Nehmen wir als Beispiel Deutschland im März 2025: Hier dominierte Chrome den mobilen Markt mit 54 % auf Smartphones, gefolgt von Safari mit 30,3 % und Samsung Internet mit 9,1 %. Solche Zahlen zeigen, worauf sich Kompatibilitätstests konzentrieren müssen, um die Mehrheit der Nutzer abzudecken. Details zur Verteilung mobiler Browser in Deutschland liefert Statista.

Gleichzeitig werden die kritischsten User Journeys identifiziert. Das sind die Pfade, bei denen ein Fehler den größten Schaden anrichtet:

Die Priorisierung dieser Bereiche stellt sicher, dass die wichtigsten Teile der Anwendung stabil bleiben.

Das folgende Diagramm illustriert den typischen Ablauf eines strukturierten Mobile Web Tests.

Der Prozess ist systematisch aufgebaut: von der grundlegenden Funktionalität über die Performance bis hin zur User Experience und Gerätekompatibilität.

Um Geschwindigkeit und Qualität zu vereinen, orientieren wir uns an der Testpyramide. Dieses Modell schlägt eine Verteilung verschiedener Testarten vor, um schnelles Feedback zu ermöglichen, ohne die Testabdeckung zu vernachlässigen. Für Mobile-Web-Projekte sieht die Struktur wie folgt aus:

Eine gesunde Testpyramide in einem Mobile-Web-Projekt hat eine breite Basis an Unit-Tests und eine schmale Spitze an E2E-Tests. Dieses Verhältnis stellt sicher, dass die meisten Fehler früh und kostengünstig gefunden werden, während die Entwicklungsgeschwindigkeit hoch bleibt.

Diese Strategie passt ideal in agile Sprints und schafft eine kontinuierliche Feedback-Schleife, die bei jedem Commit die Qualität sichert und das Risiko von Regressionen minimiert.

Die Debatte „manuell gegen automatisch“ ist überholt. In der Praxis geht es nicht mehr um „entweder/oder“, sondern darum, das Beste aus beiden Welten strategisch zu nutzen. Ein intelligenter Mix ist der Schlüssel, um beim mobile web test sowohl effizient zu sein als auch hohe Qualität zu sichern.

Manuelle Tests sind unersetzlich, wenn es um die Nuancen der User Experience geht. Kein Skript kann die Intuition oder das subjektive Empfinden eines Menschen ersetzen. Ein erfahrener QA-Tester, der eine Anwendung explorativ prüft, findet Usability-Probleme, die in keinem Testplan stehen.

Automatisierung ist der Motor für Geschwindigkeit und Wiederholbarkeit. Sie ist die Antwort auf repetitive, zeitaufwendige Aufgaben im agilen Alltag. Hunderte von Regressionstests über Nacht auszuführen, ist der einzige Weg, um kurze Release-Zyklen ohne Stabilitätsverluste zu realisieren.

Manuelles Testen ist immer dann die richtige Wahl, wenn menschliches Urteilsvermögen gefragt ist.

Automatisierung ist ideal für Aufgaben, die präzise, wiederholbar und für Menschen fehleranfällig sind. Sie spannt ein verlässliches Sicherheitsnetz auf.

Ein hybrider Ansatz ist eine strategische Entscheidung. Er kombiniert die Effizienz von Maschinen für wiederholbare Aufgaben mit der unersetzlichen menschlichen Intuition für die User Experience.

Diese Gegenüberstellung hilft bei der Entscheidung, wann welcher Ansatz am besten passt.

Die Wahl hängt vom Ziel des jeweiligen Tests ab. Für die schnelle Überprüfung von Kernfunktionen ist Automatisierung unschlagbar. Um die Anwendung durch die Augen eines Nutzers zu sehen, ist manuelles Testen unerlässlich.

Diese Checkliste hilft Teams im Projektalltag, ihre Ressourcen gezielt einzusetzen.

Wann sollte ein Testfall automatisiert werden?

Wenn die meisten dieser Fragen mit „Ja“ beantwortet werden, ist der Testfall ein klarer Kandidat für die Automatisierung.

Wann ist manuelles Testen unverzichtbar?

Hier ist menschliches Urteilsvermögen erforderlich. Der Versuch, solche Szenarien in ein starres Skript zu pressen, führt oft zu fragilen Tests und hohem Wartungsaufwand.

Wenn Sie tiefer in mobile Testmethoden, speziell für Android, eintauchen möchten, empfehlen wir unseren Artikel zum Thema Android-Apps testen. Durch die bewusste Wahl des richtigen Werkzeugs für die jeweilige Aufgabe schaffen Sie einen robusten und effizienten Qualitätssicherungsprozess.

Die Auswahl der richtigen Werkzeuge entscheidet über die Effizienz des gesamten Testprozesses. Ein gut abgestimmtes Toolset beschleunigt nicht nur die Entwicklung und liefert präzisere Ergebnisse, sondern reduziert auch Frustration im Team.

Für schnelle Checks während der Entwicklung sind Emulatoren und Simulatoren unschlagbar. Sie sind meist direkt in die IDE integriert und geben Entwicklern sofortiges Feedback zu Code-Änderungen, ohne dass ein physisches Gerät benötigt wird.

Tools wie die Chrome DevTools oder der Xcode Simulator sind für die meisten Entwickler die erste Anlaufstelle. Sie sind ideal, um schnell das Layout auf verschiedenen Bildschirmgrößen zu prüfen, CSS-Anpassungen live zu testen oder JavaScript-Fehler zu debuggen. Ihre Stärke liegt in der Geschwindigkeit und nahtlosen Integration in den Entwickler-Workflow.

Allerdings simulieren diese Tools die Realität nur – sie bilden sie nicht 1:1 ab. Hardware-Eigenheiten, spezifisches OS-Verhalten oder reale Mobilfunknetz-Bedingungen können sie nicht exakt nachahmen. Für oberflächliche UI-Checks sind sie perfekt, stoßen aber bei verlässlichen Performance- oder Kompatibilitätstests an ihre Grenzen.

Für präzise und realitätsnahe Testergebnisse sind echte Geräte unverzichtbar. Nur auf ihnen lassen sich Faktoren wie Akkuverbrauch, tatsächliche CPU-Last oder die exakte Render-Engine des Browsers zuverlässig bewerten.

Da der Unterhalt eines eigenen Geräteparks schnell teuer und aufwendig wird, haben sich Cloud-Plattformen etabliert. Dienste wie BrowserStack oder Sauce Labs bieten Zugriff auf tausende echte Smartphones und Tablets.

Diese Plattformen ermöglichen es Teams, ihre Webanwendungen gezielt auf bestimmten Geräte-Betriebssystem-Browser-Kombinationen zu testen, ohne die Hardware selbst besitzen zu müssen.

Der entscheidende Vorteil von Cloud-Plattformen liegt in der Skalierbarkeit. Man kann Dutzende von automatisierten Tests parallel auf verschiedenen Geräten laufen lassen – ein entscheidender Faktor für schnelle CI/CD-Pipelines.

Für die Automatisierung von Tests im mobilen Web haben sich drei Frameworks etabliert. Jedes hat spezifische Stärken.

Die Wahl hängt stark vom bestehenden Tech-Stack und den Fähigkeiten des Teams ab. Für Teams, die neu in die Web-App-Entwicklung einsteigen, bieten Cypress oder Playwright oft einen leichteren Einstieg als Selenium.

Eine Webanwendung, die nur im schnellen Büro-WLAN performt, versagt oft dort, wo es zählt: unterwegs beim Nutzer. Die Simulation realer Netzwerkbedingungen ist daher ein kritischer Bestandteil jedes Testprozesses. Tools wie die Chrome DevTools oder spezielle Proxys können verschiedene Netzwerkprofile wie „Slow 3G“ oder „Offline“ simulieren und so Schwachstellen aufdecken.

Umfangreiche Netztests in Deutschland zeigen immer wieder, wie wichtig dies ist. Der connect Netztest 2026 beispielsweise nutzte über 224.000 Datensamples und 12,4 Milliarden Crowdsourcing-Messwerte, um die Netzqualität zu bewerten. Die Ergebnisse offenbarten erhebliche Unterschiede zwischen städtischen und ländlichen Gebieten, was die Notwendigkeit von Tests unter diversen Bedingungen unterstreicht. Weitere Einblicke dazu finden sich beispielsweise auf inside-digital.de.

Performance ist ein zentraler Aspekt der User Experience. Eine langsam ladende Webseite führt zu Frustration und hohen Absprungraten. Ein guter mobile web test konzentriert sich daher auf die Kennzahlen, die das Nutzererlebnis direkt beeinflussen.

Googles Core Web Vitals bieten dafür einen nutzerzentrierten Leitfaden. Sie übersetzen technische Messwerte in das, was Nutzer spüren: Ladegeschwindigkeit, Interaktivität und visuelle Stabilität.

Der Largest Contentful Paint (LCP) misst, wann das größte sichtbare Element im Viewport erscheint. Ein guter Wert liegt unter 2,5 Sekunden. Er signalisiert dem Nutzer: "Die Seite lädt."

Häufige Ursachen für einen schlechten LCP-Wert:

<head> können die Darstellung der Seite blockieren.Eine effektive Maßnahme ist die Auslieferung von Bildern in modernen Formaten wie WebP oder AVIF. Lazy Loading für Bilder unterhalb des sichtbaren Bereichs ("below the fold") priorisiert zusätzlich die für den Nutzer sofort sichtbaren Inhalte.

Der First Input Delay (FID) misst die Reaktionszeit der Seite auf die erste Nutzerinteraktion. Werte unter 100 Millisekunden fühlen sich direkt an. Ein hoher FID-Wert entsteht meist, weil der Main-Thread des Browsers durch die Ausführung von JavaScript blockiert ist.

Typische Ursachen sind:

Die Lösung ist oft Code Splitting, bei dem der JavaScript-Code in kleinere Pakete aufgeteilt und nur bei Bedarf geladen wird. Das asynchrone Laden von Skripten mit async oder defer ist ebenfalls entscheidend, um das Rendern der Seite nicht zu blockieren.

Performance ist eine Daueraufgabe, kein einmaliges Projekt. Regelmäßige Messungen in der CI/CD-Pipeline sind Pflicht, um Performance-Regressionen sofort zu erkennen.

Der Cumulative Layout Shift (CLS) misst unerwartete Layout-Verschiebungen während des Ladens. Ein guter Wert liegt unter 0,1. Jeder kennt das Phänomen: Man will auf einen Button klicken, doch im letzten Moment verschiebt er sich, weil darüber ein Element nachgeladen wird.

Die Hauptgründe für einen hohen CLS-Wert:

Die Lösung: Geben Sie <img>- und <video>-Elementen immer width- und height-Attribute. Für dynamisch geladene Inhalte sollte von vornherein ein Platzhalter reserviert werden.

Die Netzqualität spielt ebenfalls eine Rolle. Der Netztest 2026 des SMARTPHONE Magazins zeigte, dass die Deutsche Telekom mit 93 Prozent bei Erfolgsraten punktet. Mehr Details zur Netzqualität in Deutschland finden Sie bei dietester.de. Dennoch kann auch das beste Netz eine schlecht optimierte Seite nicht retten.

In modernen Entwicklungsprozessen ist Testing tief im DevOps-Zyklus verankert, um schnelles und kontinuierliches Feedback zu gewährleisten. Der Schlüssel dazu ist die nahtlose Integration von Mobile-Web-Tests in die CI/CD-Pipeline.

Dieser Ansatz macht das Testen vom Flaschenhals zum Beschleuniger. Automatisierte Tests lösen bei jedem Commit oder Pull-Request selbstständig aus und schaffen eine sofortige Feedbackschleife, die fehlerhaften Code abfängt, bevor er in den Hauptzweig gemerged wird.

Moderne Tools wie GitLab CI, GitHub Actions oder Jenkins ermöglichen eine unkomplizierte Einrichtung. Eine Konfigurationsdatei – z. B. .gitlab-ci.yml – legt fest, wann und wie die Tests ausgeführt werden sollen.

Ein typischer Trigger für einen Mobile-Web-Test ist ein pull_request. Sobald ein Teammitglied neuen Code zur Überprüfung einreicht, startet die Pipeline automatisch und führt die definierte Test-Suite aus.

Hier ein Beispiel für eine GitHub-Actions-Konfiguration, die bei jedem Pull-Request Cypress-Tests startet:

name: Mobile Web Testson:pull_request:branches: [ main ]jobs:cypress-run:runs-on: ubuntu-lateststeps:- name: Checkoutuses: actions/checkout@v2- name: Cypress runuses: cypress-io/github-action@v4with:browser: chromespec: cypress/integration/mobile/**/*.spec.jsDiese Konfiguration stellt sicher, dass jede Code-Änderung sofort gegen eine Reihe von Tests für mobile Szenarien validiert wird.

Ein fehlgeschlagener Build muss sofort sichtbar sein und Konsequenzen haben. Die Integration in Kollaborationstools ist hier entscheidend. Schlägt ein Test fehl, sollte dies direkt im Pull-Request angezeigt werden und das Mergen blockieren.

Zusätzlich sind automatische Benachrichtigungen über Slack, Microsoft Teams oder E-Mail unerlässlich, um das zuständige Team umgehend zu informieren. Dies fördert eine Kultur der Verantwortung.

Tests in die CI/CD-Pipeline zu integrieren, ist mehr als nur Automatisierung. Es ist ein kultureller Wandel, der Qualität zur gemeinsamen Aufgabe des gesamten Teams macht und das Vertrauen in jeden Deploy stärkt.

Ein weiterer wichtiger Baustein ist die automatische Erstellung von Test-Reports. Diese Berichte, oft als HTML-Artefakte archiviert, liefern detaillierte Einblicke in fehlgeschlagene Tests – inklusive Screenshots oder Videos zum Fehlerzeitpunkt. Dies beschleunigt die Fehleranalyse erheblich.

Hier sind Antworten auf die häufigsten Fragen, die im Projektalltag rund um das Mobile Web Testing aufkommen.

Ein Simulator ahmt die Softwareumgebung eines Geräts nach, zum Beispiel iOS. Ein Emulator hingegen bildet sowohl die Hardware als auch die Software ab, etwa bei Android-Geräten.

Für einen schnellen UI-Check während der Entwicklung reicht oft ein Simulator. Für präzise Performance-Tests oder die Untersuchung von Kompatibilitätsproblemen sind Emulatoren oder – noch besser – echte Geräte notwendig, um verlässliche Ergebnisse zu erhalten.

Es gibt keine magische Zahl. Der beste Ansatz ist risikobasiert. Analysieren Sie Ihre Nutzerdaten: Welche Geräte, Betriebssysteme und Bildschirmgrößen werden am häufigsten verwendet?

Konzentrieren Sie Ihre Testressourcen auf diese Segmente. Ergänzen Sie Ihre Tests um einige ältere, aber noch verbreitete Geräte, um die Abwärtskompatibilität sicherzustellen, ohne das Budget zu sprengen.

Die goldene Regel lautet: Testen Sie nicht alles, sondern testen Sie smart. Eine datengestützte Auswahl ist effektiver als blindes Testen auf hunderten Geräten.

Accessibility Testing ist essenziell. Es stellt sicher, dass Ihre Anwendung für alle zugänglich ist – einschließlich der 1,3 Milliarden Menschen weltweit, die mit einer Behinderung leben.

Eine barrierefreie Anwendung verbessert nicht nur die User Experience für alle, sondern erweitert auch Ihre potenzielle Reichweite. Konzentrieren Sie sich auf folgende Aspekte:

Die frühzeitige Integration dieser Tests in den Entwicklungsprozess spart spätere Korrekturaufwände und führt zu einem besseren, inklusiveren Produkt.

Sie wollen sicherstellen, dass Ihre Webanwendung den höchsten Qualitätsstandards entspricht? Bei PandaNerds verstärken wir Ihr Team mit erfahrenen Senior-Entwicklern, die Ihre Software auf Herz und Nieren prüfen. Skalieren Sie Ihre Software-Fähigkeiten mit uns.